‘Software’ per caçar els qui discriminen per sexe a Silicon Valley

Als Estats Units creixen les empreses dedicades a detectar automàticament el biaix per sexe o edat en els processos de contractació, ascens o acomiadament dels treballadors

Entre els caps de recursos humans de les empreses tecnològiques són habituals almenys dos prejudicis: contractar gairebé sempre homes que gairebé sempre són molt joves. A Silicon Valley proliferen les acusacions, clares o velades, de sexisme i ageism, el terme anglosaxó per definir la discriminació per edat, i els primers sorpresos són els directius que es creien fills exclusius de la meritocràcia i lliures de qualsevol altre biaix que alterés les seves decisions a l'hora de contractar, promocionar o acomiadar un empleat.

No obstant això, com bé diu Howard Ross, autor del llibre Every day bias: Identifying and navigating inconscious judgements in our daily lives (Els biaixos de cada dia: Un viatge pels judicis inconscients de la nostra vida diària): “Si ets humà, tens prejudicis, és una cosa que ha quedat demostrada en més de mil estudis durant la darrera dècada”. Segons Ross, l'impacte dels biaixos inconscients en la vida laboral és “dramàtic”.

Almenys per combatre el biaix de sexe, a Silicon Valley han decidit posar límit als seus propis prejudicis. I de la manera com millor ho saben fer: a través d'algorismes, programari i tecnologia de geolocalització.

Silicon Valley carrega amb l’etiqueta de contractar gairebé sempre homes que gairebé sempre són molt joves

Les companyies que es dediquen a identificar i neutralitzar biaixos en entrevistes de feina i avaluacions d'empleats estan en voga. Treballen amb una tecnologia que processa el llenguatge utilitzat i les emocions, i estan rebent importants sumes de diners en rondes de finançament.

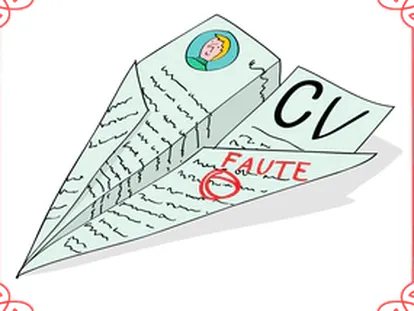

Una d'aquestes empreses, Textio, acaba de recaudar 1,5 milions de dòlars (1,35 milions d'euros) amb la promesa d'identificar qualsevol biaix de gènere en les paraules que s'empren en les ofertes de feina i en les avaluacions a empleats abans d'una promoció. Gràcies a la precisió del seu algorisme, s'ha comprovat que si una oferta inclou la frase “busquem un candidat amb un historial laboral verificable”, es presentarien més homes a la convocatòria. En canvi, si es demanava un candidat “amb passió per aprendre”, respondrien més dones. Resulta difícil arribar a aquesta conclusió si no és a través de l'encreuament de dades i informació d'un programari.

Les companyies que es dediquen a identificar i neutralitzar biaixos en entrevistes de feina i avaluacions d’empleats estan en voga

Els ocupadors de Silicon Valley han decidit no confiar en el seu criteri i deixar que un algorisme corregeixi els seus biaixos inconscients de gènere. Per això companyies com Textio s'estan convertint en un gran negoci.

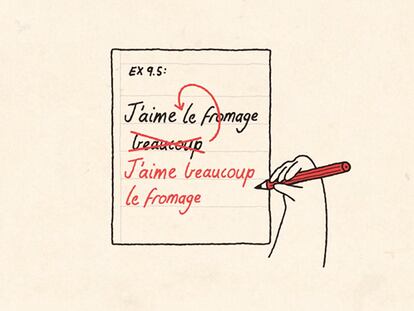

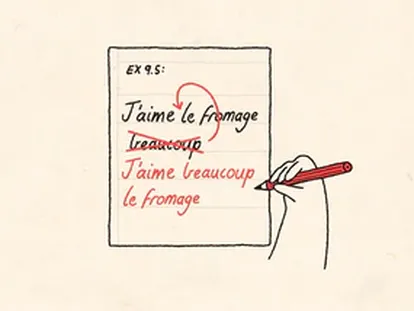

Kanjoya també es dedica a rastrejar prejudicis. En aquesta empresa treballen amb una tecnologia “processadora del llenguatge i de les emocions conscients” desenvolupada durant vuit anys en col·laboració amb lingüistes de la Universitat de Stanford. Segons explica a EL PAÍS el seu fundador i director, Armen Berjikly, el seu algorisme és tan exacte que ha aconseguit descobrir que la paraula assertivitat s'utilitza com un terme negatiu en les avaluacions a les dones, mentre que quan s'inclou en l'avaluació d'un home no només es considera un atribut positiu, sinó que constitueix el pas previ a un ascens. Segons explica Berjikly, només un biaix inconscient pot explicar que la mateixa paraula sigui bona per a uns i dolenta per a d'altres.

“La tecnologia de Kanjoya no només analitza les paraules, sinó també l'emoció i intenció que hi ha al darrere. Aquesta informació es combina amb la decisió que s'ha pres; és a dir, si la persona avaluada ha estat acomiadada, ascendida o contractada. Dividim les dades en segments d'edat, ètnia, gènere, geografia… i es pot veure immediatament el que ha representat un èxit per a uns i un fracàs per a d'altres. En un món ideal, sense biaixos, el llenguatge per justificar un ascens o un acomiadament hauria de ser el mateix per a tots. No obstant això, no ho és gairebé mai. La gent espera unes coses dels homes i unes altres de les dones, i el fet interessant és que ni tan sols se n'adonen. El nostre producte identifica i mesura aquests biaixos, i aquest és el primer pas per eliminar-los d'una empresa. No es pot arreglar el que no s'ha mesurat”.

Kanjoya, fundada el 2007, ha obtingut un finançament de 20 milions de dòlars (18 milions d'euros) de diversos inversors, entre els quals hi ha D. I. Shaw. Entre els seus clients trobem Twitter i Cisco.

Unitive.works, que probablement comenci a operar al juny, serà una altra de les empreses dedicades a caçar prejudicis amagats i inconscients. La seva missió és etiquetar-los i situar-los geogràficament en temps real, com una mena de Google Maps dels biaixos. La seva tecnologia es concentra en els processos de reclutament i contractació de personal, i té la capacitat d'interrompre el biaix en el mateix moment en què apareix. Per exemple, en una entrevista de feina o en la redacció d'una oferta d'ocupació.

Segons el diari The Wall Street Journal, el 20% de les grans empreses nord-americanes està entrenant els seus empleats en la identificació d'aquest tipus de prejudicis i en els propers cinc anys podrien fer-ho el 50%. Google és una de les companyies que ha decidit corregir els seus prejudicis de portes endins, fent servir un programa de formació interna perquè els seus empleats siguin més conscients dels seus biaixos de gènere, edat o nacionalitat.

No obstant això, alguns consultors no creuen que aquesta estratègia funcioni. Joelle Emerson, directora i fundadora de Paradigm, una consultora estratègica que treballa amb les empreses perquè eliminin els seus “biaixos estructurals”, no recomana que les companyies intentin identificar els seus prejudicis pel seu compte. “Al capdavall, per alguna cosa són inconscients”, qüestiona. Armin Berjikly tampoc ho veu viable. “La tecnologia per fer-ho resulta difícil de construir. Nosaltres vam trigar vuit anys dissenyar models perfectes i precisos per mesurar emocions. D'altra banda, és complicat fer una revisió independent dels biaixos a càrrec de les persones que estan exposades o han estat afectades o afavorides per ells”. Segons explica el fundador de Kanjoya, en les empreses en què han identificat prejudicis contra les dones els mateixos empleats els ho han acabat agraint. El motiu: feia temps que sospitaven de certes conductes però no se les prenien seriosament “per falta de dades” i “per falta d'independència”. “Nosaltres els hem proporcionat totes dues coses”, afirma Berjikly.

El director de Kanjoya creu, igual que molts a Silicon Valley, que no hi ha religió més enllà de la tecnologia. “No hi ha res més fiable que la tecnologia, perquè en si mateixa ja és independent respecte a la mesura; no té biaixos, no té agenda, no té interessos polítics, i sempre es pot millorar”.

“Tots volem treballar en un ambient just on siguem avaluats per coses que es poden controlar, i no per estereotips. Si en una companyia s'utilitza una tecnologia com la de Kanjoya la gent no haurà de pensar que està imaginant coses i només assumirà els fets contrastats”. Així explica Armen Berjikly l'èxit dels programes que mesuren i neutralitzen els biaixos inconscients. També li serveix l'argument de l'arribada dels millenials, la generació més diversa dels Estats Units, al mercat laboral.

Calen més algorismes 'caçaprejudicis'

Això de caçar biaixos de gènere amb un algorisme no és cap excentricitat dels techies de Califòrnia. El mateix Berjikly rastreja els resultats d'una enquesta realitzada per PWC a gairebé 5.000 joves que acabaven d'incorporar-se al mercat laboral de 75 països, entre els quals Espanya. El 29% de les noies van dir que sentien que els seus caps tenien una actitud molt esbiaixada a favor dels homes quan havien de fer promocions internes, mentre que el 46% dels nois va considerar que els ascensos es feien en condicions d'igualtat. El 61% dels homes entrevistats creien que podien arribar al capdavant de l'empresa, una cosa que només li passava pel cap al 50% de les dones. A l'enquesta els ocupadors brasilers van resultar ser els que tenien menys prejudicis i els espanyols van ser considerats els més esbiaixats a favor dels homes. Aquesta última línia me la dóna Berjikly subratllada i en negreta: "Calen algorismes caçaprejudicis més enllà de Silicon Valley".

Sobre la firma